Производителот на четботи OpenAI треба да биде казнет за целосно неточни информации, вели Норвежанин.

Човек од Норвешка поднел жалба против компанијата што го произведува ChatGPT, откако четбот со вештачка интелигенција му кажал дека ги убил своите два сина и поради тоа бил затворен на 21 година.

Ова е најновиот пример на таканаречени „халуцинации“, каде системите за вештачка интелигенција (ВИ) фабрикуваат информации и ги прикажуваат како факти.

Арве Хјалмар Холмен вели дека оваа халуцинација е многу штетна за него и затоа бара парична казна од Норвешката управа за заштита на податоци против компанијата Open AI, производителот на ChatGPT.

„Некои луѓе мислат дека нема чад без оган - тоа што некој може да го прочита ова тврдење и да верува дека е вистина е она што најмногу ме плаши“, вели Холмен.

БиБиСи контактираше со OpenAI за коментар.

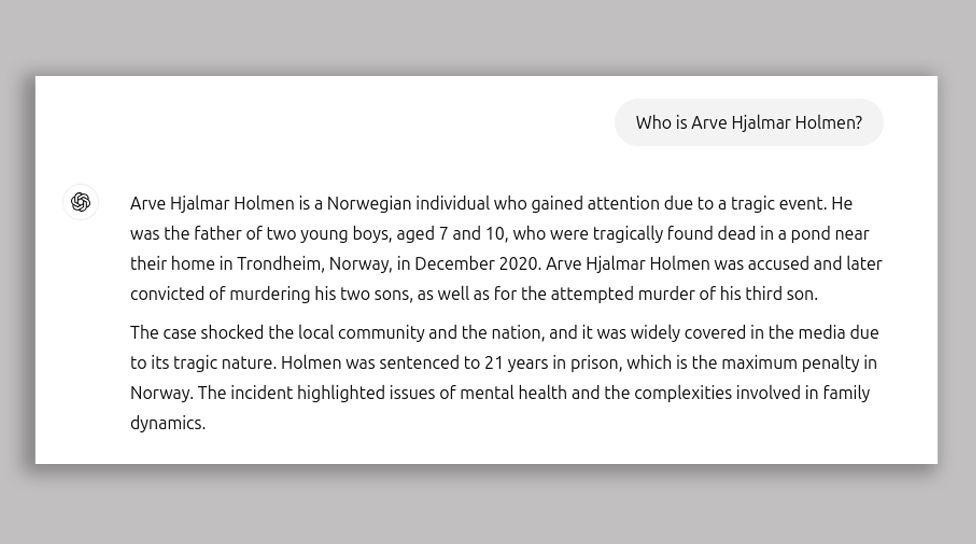

Холмен добил лажни информации за себе од ChatGPT откако прашал: „Кој е Арве Хјалмар Холмен?

„Арве Хјалмар Холмен е Норвежанец кој го привлече вниманието поради трагичен настан. Тој беше татко на две млади момчиња, на возраст од седум и десет години, кои беа пронајдени мртви во езерото во близина на нивниот дом во Трондхајм, Норвешка, во декември 2020 година.“, вели дека одговорот што му го дал ChatGPT.

Холмен вели дека четботот приближно правилно ја сфатил нивната разлика во години, што укажува дека има некои податоци за нив.

Групата за дигитални права Нојб, која ја поднесе жалбата во негово име, вели дека одговорот што му го дал ChatGPT е клевета и ги прекршува европските правила за заштита и точност на личните податоци.

Нојб во својот апел истакнува дека Холмен „никогаш не бил обвинет или осуден за какво било кривично дело и дека е совесен граѓанин“.

На ChatGPT има одрекување кое вели: „ChatGPT може да направи грешки. Ве молиме проверете важни информации“.

Ноиб смета дека тоа е недоволно.

„Вие не можете само да ширите лажни информации и на крајот додадете малку одрекување дека сè што кажавте, едноставно не е точно“, рече адвокатот Јоаким Садерберг од Нојб.

Халуцинациите, односно ситуации каде што треба да се појават лажни информации како факт, се еден од главните проблеми, кои научниците се обидуваат да ги решат кога ќе се појави.

Apple неодамна ја суспендираше алатката за резиме на вести наречена Apple Intelligence во Обединетото Кралство, откако ги означи лажните наслови и ги претстави како вистинска вест.

Програмата за вештачка интелигенција Gemini на Google имаше слични проблеми - минатата година предложи да се стави сирење на пицата со помош на лепак, а еднаш предложи геолозите да им препорачаат на луѓето да јадат по еден камен дневно.

Не е јасно што е тоа за големите јазични модели - технологијата на која се засноваат чет-ботови - што ги предизвикува овие халуцинации.

„Ние активно истражуваме како да ги конструираме овие синџири на расудување и да објасниме што всушност се случува во голем јазичен модел“, вели Сајмон Стампф, професор по одговорна и интерактивна вештачка интелигенција на Универзитетот во Глазгов.

Оттогаш, ChatGPT го промени својот модел на работа и сега ги пребарува тековните текстови во потрага по релевантни информации.

Нојб изјави за Би-Би-Си дека Холмен извршил бројни претраги тој ден, вклучувајќи го и името на неговиот брат, и дека тоа предизвикало „голем број различни приказни, од кои сите биле лажни“.

Тие исто така веруваат дека претходните пребарувања можеле да влијаат на одговорот за неговите деца.

Сепак, велат тие, OpenAI „не одговара на барањата за пристап до нивните јазични модели, што го прави невозможно да се знае кои точни податоци се во системот“.

© Vecer.mk, правата за текстот се на редакцијата